PyTorchやTensorFlow互換のAI処理高速化プラットフォーム「MAX」プレビュー公開、Pythonを高速化した「Mojo」搭載

Modular社がAI処理を高速化するプラットフォーム「MAX」をプレビュー公開。PyTorchやTensorFlow、ONNXなどのAIモデルと入れ替えるだけで処理が最大5倍高速になる。

Pythonの高速なスーパーセット「Mojo」言語を発表したことで話題となったModular社が、AI処理を高速化するプラットフォーム「MAX」(Modular Accelerated Xecution)のデベロッパーエディションをブレビュー公開しました。

MAX Developer Edition Preview has officially launched! It's a drop-in replacement for running and serving @PyTorch, @tensorflow and @onnxai models much faster and leverages the power Mojo for extensibility. Check out the blog posthttps://t.co/z6Nul9DADk

— Modular (@Modular) February 29, 2024

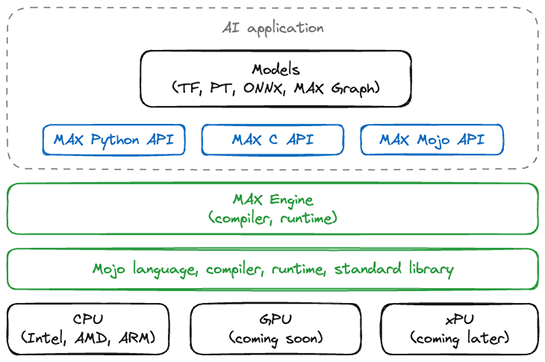

MAXは、AIの推論処理を高速に実行する「MAX Engine」、推論処理にアクセスするためのAPIなどのサービングシステムを提供する「MAX Serving」、そして高速な処理を実現するPython互換のプログラミング言語「Mojo」から構成されています。

MAXは2023年12月のイベント「ModCon '23」で発表され、今回デベロッパーエディションが公開されました。

ModCon '23で発表されたMAX

ModCon '23で発表されたMAX今回の注目点はMAX Engineが公開されたことでしょう。

MAX Engineは、推論処理を高速化するコンパイラおよびランタイムです。PyTorch、TensorFlow、ONNX形式のAIモデルであるMistral、Stable Diffusion、Llama2、WevLM、MLMR、ClipVitなどをサポートしており、これらの推論処理をMAX Engineに置き換えることで最大5倍高速なAI処理を実現します。

Modular社はベンチマーク結果も公開しており、Mistral-7Bは3.3倍、Stable Diffusionは1.7倍、Llamaでは2.3倍、MAX Engineの方が高速だとしています。

MAXのためのMAX SDK Developer Editionは現時点でUbuntu Linux版のみで、今後macOS版、Windows版のリリースも予定されています。

ただしMojo言語はすでにLinux版、macOS版が公開されています。

- Pythonの高速なスーパーセットをうたう新言語「Mojo」、コンパイラなど公開、ローカル環境で利用可能に

- 高速なPython互換言語「Mojo」のMac版登場、Appleシリコンにネイティブ対応。Pythonの9万倍、C言語に比肩する高速性

また今後は本番環境で利用可能なEnterprise Editionの提供、GPUへの対応なども進めていくとしています。

関連記事

あわせて読みたい

WebAssemblyとWebGPUを用い、Webブラウザ上でStable Diffusion Turbo全体を高速実行可能な推論エンジン「ONNX Runtime Web 1.17」マイクロソフトから登場

≪前の記事

ウクライナ軍に入隊したアジャイルコーチがメソッドを駆使/Web版VSCodeがDockerコンテナをWASM環境で起動/無料のLinuxサーバー構築標準教科書ほか、2024年2月の人気記事