高速なPython互換言語「Mojo」を用いたAIプラットフォーム「MAX」発表。ModCon '23

高速なPython互換言語「Mojo」の開発元であるModular社は、同社として初のイベント「ModCon '23」を12月4日にサンフランシスコで開催しました。

基調講演では、AI処理を高速に実行するプラットフォーム「MAX」(Modular Accelerated Xecution (MAX) Platform)が発表されました。

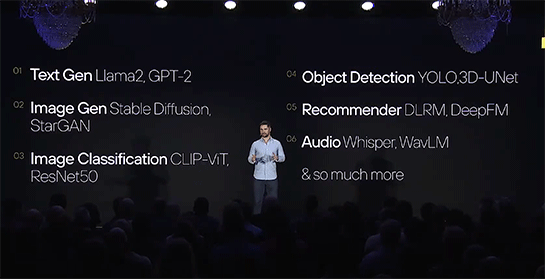

MAXはオンプレミスやクラウドにインストール可能なソフトウェアであり、AIの推論処理を高速に実行する「MAX Engine」、推論処理にアクセスするためのAPIなどのサービングシステムを提供する「MAX Serving」、そして高速な処理を実現するプログラミング言語である「Mojo」から構成されています。

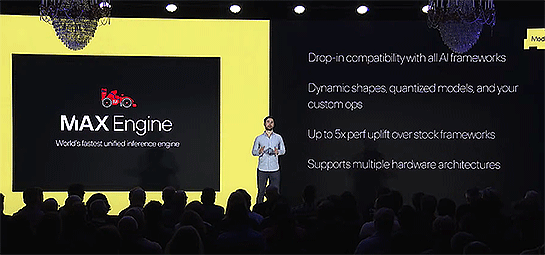

MAX Engine

PyTorchやTensorFlowなど既存のAIフレームワークすべてに対応し、書き換えや変換をすることなくあらゆるハードウェア環境やクラウド環境で高速な推論処理を実行します。同社は従来の実行環境より5倍高速だとしています。

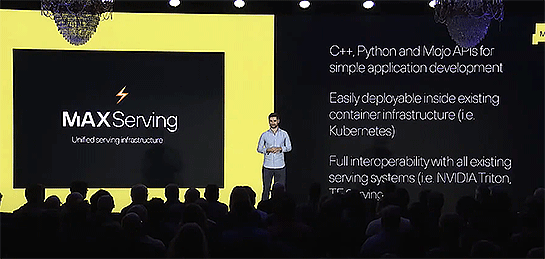

MAX Serving

MAX ServingはMAX Engineのためのサービングライブラリとして、TritonやTorchServeなど既存のサービングシステムとの完全な相互運用性を提供し、PythonやC++、Mojoによるアプリケーション開発のためのAPIを提供。Kubernetesなどコンテナ環境に簡単にデプロイ可能。

Mojo

高速なPython互換言語のMojoでMAX全体が実現されています。

MAXはAI処理をスケールさせる

現在、たとえ世界最大の企業の優秀な技術者集団であっても、生成AIの処理をスケールさせることが非常に困難になってきているという課題に直面していると。

MAXはその課題を解決するソリューションを提供すると説明されました。

MAXは非商用目的であれば無料で利用可能な「Developer Edition」と、商用目的で利用可能な有償の「Commercial Edition」が提供されます。

またModular社はAWSと提携し、来年(2024年)第1四半期にはMAXをAWS Marketplaceで提供することも合わせて発表しました。

さらに、MAXをGPU対応にすることで、さらに高速な処理を実現させる「MAX GPUs」も発表されました。

参考:高速なPython互換言語の「Mojo」、そのままGPUで実行可能に。「MAX GPUs」発表。ModCon '23

2024年3月追記:MAXのデベロッパープレビュー版が公開

- [PyTorchやTensorFlow互換のAI処理高速化プラットフォーム「MAX」プレビュー公開、Pythonを高速化した「Mojo」搭載]

あわせて読みたい

高速なPython互換言語の「Mojo」、そのままGPUで実行可能に。「MAX GPUs」発表。ModCon '23

≪前の記事

クラウドやオンプレミスでOS/アプリ/DBを同時に高可用化するHAクラスタリングソフトウェア、Linuxのライブパッチでさらに長期の高可用を実現へ[PR]