10年前に「ムーアの法則が終わる」と言われた頃から現在までのサーバ進化の技術的模索を振り返る(前編)

先々月、あるサーバベンダ主催のイベントで、最近のサーバにおける技術トレンドを紹介して欲しいという依頼を受けて、過去10年のサーバ技術のトレンドを振り返るという講演を行いました。

ほぼ10年前は「ムーアの法則が終わる」と本格的に言われ始めた頃で、そこから実はさまざまな技術、例えばストレージクラスメモリやFPGAやメモリドリブンコンピュータなどのプロセッサの回路の微細化以外の技術によるサーバの性能向上技術が注目され、その一部は市場に投入され定着しつつある一方で、商業的な成功を収められなかった多くの技術もありました。

それらをざっと振り返る内容にしたところ、現在のサーバ技術の方向性がなんとなく見えてきたのではないかと思うので、ここで記事として紹介します。

記事は前編と後編に分かれています。いまお読みの記事は前編です。

10年前、「ムーアの法則」が終わると言われ始めた

今から約10年ほど前、2012年から2013年頃は「ムーアの法則」が終わると本格的に言われ始めた時期にあたります。

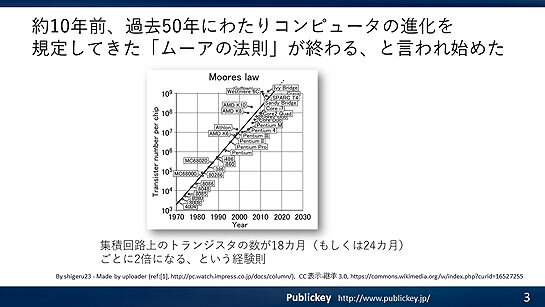

「Moores law (1970-2011)」。CC 表示-継承 3.0

「Moores law (1970-2011)」。CC 表示-継承 3.0ムーアの法則は多くの方がご存じだと思います。集積回路上のトランジスタの数が18カ月、もしくは24カ月ごとに2倍になるという経験則です。

ムーアの法則に従ってプロセッサの集積回路が細かくなることで動作速度が上がり、消費電力が下がるなど、過去50年以上にわたってコンピュータの高機能化、高速化、小型化、省電力化、低価格化などが実現されてきました。

そうした中で、2012年5月のTIME誌には「The Collapse of Moore’s Law: Physicist Says It’s Already Happening」という記事が掲載され、物理学者ミチオ・カク氏によるムーアの法則の終わりが近いとの発言が紹介されています。

国内でも2013年7月のPC Watchに「20nmプロセスから先はムーアの法則の意味がなくなる?」という記事が掲載され、ムーアの法則の先行きが危ぶまれていることが伝えられています。

この時期には、ムーアの法則が終わろうとしているという雰囲気がIT業界全体を覆っていたと言ってよいと思います。

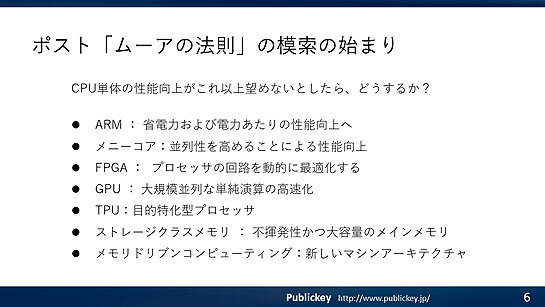

そして、ムーアの法則が終わったあと、つまりCPU単体での性能向上が難しくなったとしても、コンピュータの性能を向上させるにはどうすればよいか、技術的模索によってさまざまなベンダからさまざまな技術が登場しました。

ここでは、この過去10年に行われたポスト「ムーアの法則」時代に対するこれらの技術的模索を振り返り、その成功や失敗などを見つつ、現時点でサーバの進化はどうなっているのか、について見ていきたいと思います。

ARMプロセッサへの注目

ポスト「ムーアの法則」時代に最初に注目が集まった代表的な技術の1つは、ARMプロセッサでした。

回路の微細化による大量の発熱が課題となりつつある中で、低消費電力で低発熱なARMプロセッサを新たな選択肢と考える人が多かったためです。

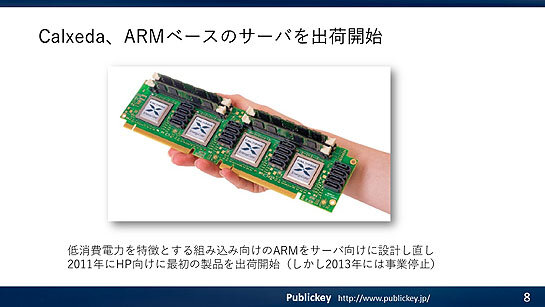

エンタープライズ向けの展開としては新興企業のCalxedaがARMベースのサーバを出荷開始しました。

しかしビジネス的には成功せず、Calxedaは2013年に事業を停止しました。

AMDも2016年にARMベースのデータセンター向けプロセッサである「Opteron A1100」をリリースしました。

しかし残念ながら後続製品は登場しませんでした。

こうしてARMプロセッサは、エンタープライズ向け市場で期待されつつも失敗が続いてきたわけですが、この流れを大きく変えることになったのが、2018年にAWSがARMベースの独自プロセッサ「AWS Graviton Processor」を発表したことでしょう。

AWSがクラウド向けのプロセッサとしてARMにコミットしたことは、ARMプロセッサがエンタープライズ向け市場で十分に戦える能力があることを示す上で、非常に大きなインパクトのある出来事でした。

2020年にはAppleがAppleシリコンを発表し、Intel Macよりも高性能なMacを実現したことも大きな出来事です。

それまでARMプロセッサは、前述のAWS Gravitonも含めて電力効率は高いけれども絶対性能ではx86/AMD64プロセッサに劣る、というのが一般的な評価でした。

しかしAppleシリコン搭載のMacがIntel Macよりも非常に高い性能を実現したことが広く知られるようになったことで、ARMはx86/AMD64と性能面で肩を並べうるだけでなく、それ以上のポテンシャルがあると多くの人が考えるようになりました。

2021年にAWSはさらに進化させたAWS Graviton 3を発表、2022年にはマイクロソフトやGoogleも相次いでクラウドでARMサーバの採用を発表するなど、ARMプロセッサはポストムーアの法則の時代を見据えたエンタープライズ市場において、重要な選択肢の1つになりつつあると言って良いのではないでしょうか。

マルチコアからメニーコアへ

ムーアの法則の継続が危ぶまれるようになったことで表れたプロセッサの分かりやすい変化が、マルチコア化やメニーコア化でしょう。

微細化のペースが落ちて1コアあたりの性能向上がゆるやかになったとしても、そのコアを増やすことで全体としての機能向上や性能向上を維持しようとするアプローチです。

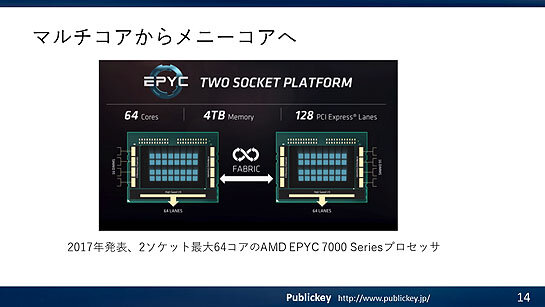

デスクトップ向けのプロセッサに比べると、サーバ向けプロセッサにおけるメニーコア化には時間がかかりましたが、本格的なメニーコアといえるサーバ向けのプロセッサとしては、2017年にAMDが発表した2ソケット64コアの「AMD EPYC 7000 Seriesプロセッサ」が挙げられます。

2018年にはインテルも最大56コアのXeon Cascade Lake-APを発表。

メニーコア化のアプローチは現在も進展しており、2023年時点ではAMD EPYCは最大96コア、第四世代インテルXeonは最大60コアとなっています。

ポスト「ムーアの法則」時代に向けた技術的なアプローチとしてメニーコアは現時点で性能向上のための主流であると言ってよいのではないかと思います。

FPGAのCPUへの統合

エンタープライズ向けサーバの主流となっているx86/AMD64に代表される汎用プロセッサの性能向上が、ムーアの法則が終わることによって困難になるのであれば、目的に特化した専用のプロセッサを組み合わせることでそこから先の性能向上を実現することが可能ではないか、というアプローチもありました。

その1つがFPGA(Field Programmable Gate Array)の活用です。

FPGAは、プロセッサのロジックをソフトウェアで書き換える能力を備えているため、特定のプログラムをハードウェアのスピードで実行可能です。それゆえに非常に高速かつ低消費電力で特定の処理を実行できます。

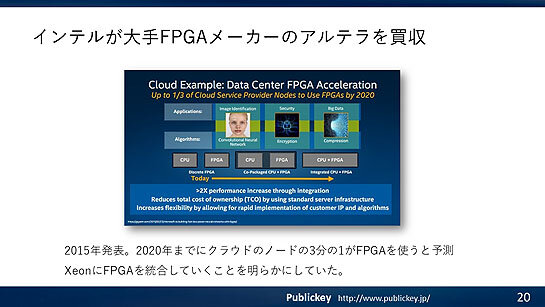

インテルは2015年、大手FPGAメーカーであるアルテラの買収を発表。XeonプロセッサにFPGAを統合していくロードマップを明らかにしました。

汎用プロセッサで苦手な処理をFPGAによって補うことで、プロセッサ全体の性能向上を目論んだのです。

2016年にはAWSもクラウド上でFPGAを提供するサービスを開始。FPGAへの注目が高まりました。

2020年にはAMDも大手FPGAメーカーのXilinxの買収を発表。インテル、AMDともに自社製品のライアンナップにFPGAを持つことになりました。

とはいえ、現時点でインテルのXeonにFPGAは組み込まれていません。

AMDがデスクトップ向けにFPGAを内蔵したプロセッサの提供をしてはいますが、少なくともエンタープライズ市場におけるサーバ用途でFPGAは主流となっているとはいえないでしょう。

GPUによる機械学習やAI処理などの高速化

目的に特化した専用のプロセッサを活用することでシステム全体としての性能向上を実現するアプローチとして、FPGAよりも現時点で成功しているのがGPUでしょう。

GPUは大量のプロセッサコアを並べることで大量の単純な演算処理を文字通り汎用のCPUよりも桁違いに超高速で実行できる半面、条件分岐のような複雑な処理を苦手とします。

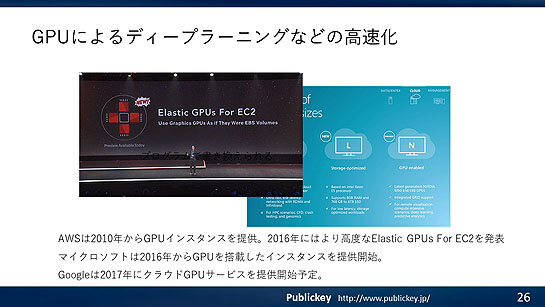

AWSは2010年からGPUインスタンスを提供、2016年にはより高速なElastic GPUs for EC2を発表しています。マイクロソフトは2016年からGPUを搭載したインスタンスを提供開始。Googleは2017年にクラウドGPUサービスを提供開始。

ポスト「ムーアの法則」時代において、機械学習やAIなどの処理の高速化にGPUは欠かせないデバイスとなっています。

ただしその利用方法としては、自社サーバに組み込むと言うよりも、クラウド経由で利用することのほうが活発になると見られます。

あわせて読みたい

10年前に「ムーアの法則が終わる」と言われた頃から現在までのサーバ進化の技術的模索を振り返る(後編)

≪前の記事

静的サイトジェネレータ「Astro 3.0」正式リリース。JavaScriptなしでSPAのようなアニメーションの画面遷移など新機能