大規模データ分析システムの現在。Asakusa Frameworkの実力、Azureの多機能、シスコのハイブリッドクラウドソリューションを見る[PR]

大規模に収集したデータを分析して企業の意思決定に生かすということが、一般的になろうとしています。この新しいビジネスニーズに合致する大規模データ分析システムとは、どのようにあるべきなのでしょうか。

シスコシステムズ合同会社および日本マイクロソフト株式会社の協賛のもと、株式会社ノーチラス・テクノロジーズ主催の「IoT時代のハイブリッドクラウドによる最新のデータ活用セミナー」が10月初旬に開催されました。

各社による大規模データ分析のためのソリューションを見ていきましょう。

シスコのIntercloud Fabricでハイブリッドクラウドを実現

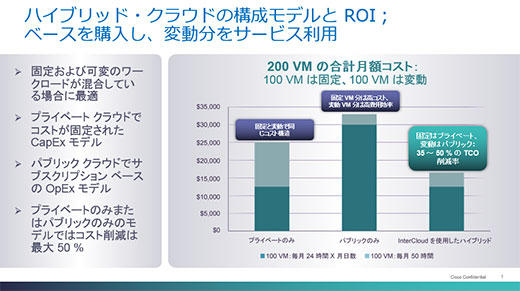

大規模なデータ処理をおこなうための基盤とはどうあるべきなのか。その効率性を考えると「プライベートクラウドとパブリッククラウドのバランスをとったハイブリッドクラウドの活用が望ましいのではないか」と説くのは、シスコシステムズのコンサルティングシステムエンジニア 石井伸武氏。

「必要なハードウェアを社内で全部用意すると、ワークロードによってはたまにしか使わないマシンが出てくる。一方、すべてをパブリッククラウドで処理しようとすると、かえってコストがかかる場合がある。この2つを組み合わせるとワークロードとコストのバランスがとれる」と語るのは、石井氏から説明を引き継いだ同じくコンサルティングシステムエンジニアの三好友成氏。

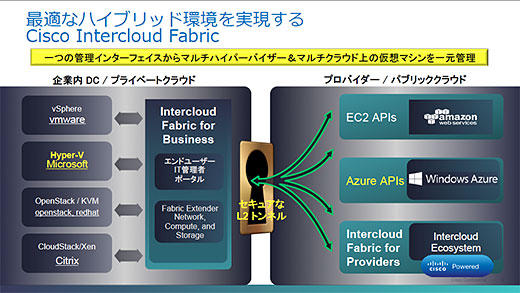

そこで同社が提案するのがハイブリッドクラウドソリューションの「Cisco Intercloud Fabric」です。

ハイブリッドクラウドには、社内と社外のクラウドで管理やセキュリティ対策が別々になったり、あるいは情報部門が知らない間に別部門が独自にクラウドの利用をはじめてしまう、いわゆる「シャドウIT」が現れたりと、いくつかの課題があります。

Intercloud Fabricは、こうした課題に対するソリューションを提供するものです。社内のプライベートクラウドに対して、Amazon Web Services、Microsoft Azureなどのパブリッククラウドに暗号化されたセキュアなL2トンネルで接続し、データの移行を柔軟に実現するだけでなく、同一のIPアドレス空間で管理が可能で、しかもvSphere、Hyper-V、KVM、Xenなどのマルチハイパーバイザ環境に対応します。

1つの管理画面上でプライベートクラウドもパブリッククラウドもサーバリソースの管理ができます。

これによって、プライベートクラウドのリソースが足りなくなったときにはパブリッククラウドのリソースを柔軟に活用でき、シャドウITに対してもガバナンスを効かせて巻き取っていくことが可能になるでしょう。

Intercloud Fabricはすべて仮想アプライアンスで実現するため、新しい機器などの購入は不要、全部ソフトウェアで実現されるため、導入のハードルも低いといえます。

Asakusa Frameworkで、これまでできなかった分析を可能に

プライベートクラウド、パブリッククラウドにかかわらず、こうしたプラットフォームが得意とする分散処理を活用して企業活動に役立てようとするのが、ノーチラス・テクノロジーズです。

「われわれは分散処理にフォーカスし、これを使って企業のボトルネックを解消することをビジネスにしています」(同社 取締役 中田明氏)

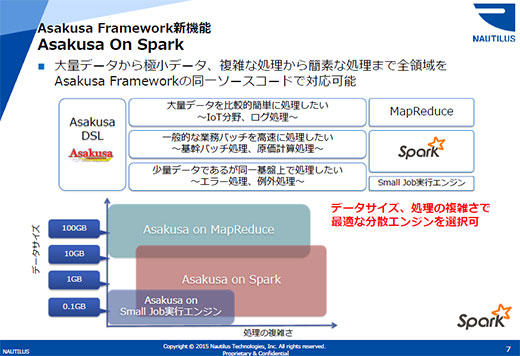

同社が展開しているのが、分散処理技術を身近にする「Asakusa Framework」です。これはバッチの高速処理を目的としたHadoop対応のフレームワーク。業務処理を記述しやすく開発された用途別の言語を用いてアプリケーションを記述してコンパイルすると、複雑なMapReduceのプログラミングを自動生成し高速処理を実現するというもの。

このAsakusa Frameworkは最近になってインメモリで分散処理する「Spark」にも対応しました。「これまでAsakusa Framework用に作ったプログラムは、リコンパイルするだけでSparkに対応する」(中田氏)

将来的にはHadoop、Sparkだけでなくさらに新しいソフトウェアやハードウェア向けにコードを生成するようにしていくとも説明されました。

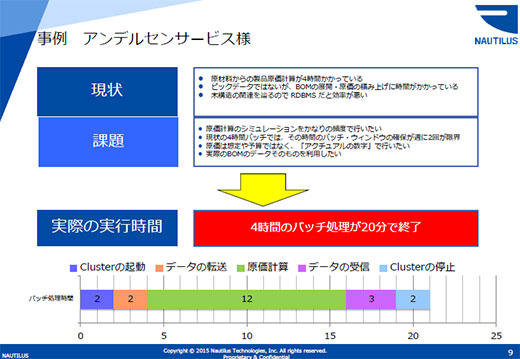

このAsakusa Frameworkには、すでに多数の実績があります。その1つがベーカリーのビジネスで知られるアンデルセングループのアンデルセンサービスによる事例です。

同社が行っているのは、水、小麦粉、卵、ハムなどさまざまな原材料を組み合わせて作るパンをいくらで売ればいくらの利益が出るのかといった、原価計算のシミュレーション。従来は4時間かけて行っていたバッチ処理ですが、Asakusa FrameworkとHadoopの組み合わせによって20分にまで短縮されています。

「クラウドに必要なデータを転送して、クラスタを起動して、計算して、トータル20分です。しかも利用料が1000円とか2000円とか」(中田氏)。これにより、お客様は1日に何回もビジネスのシミュレーションができるようになったとのこと。

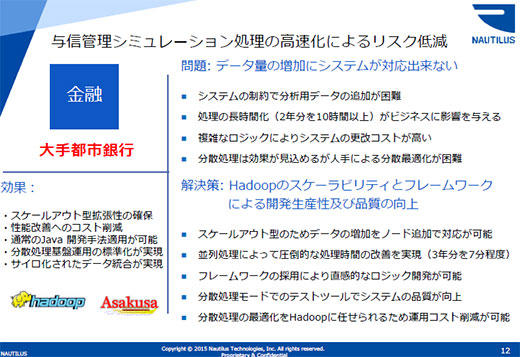

ある大手都市銀行では、融資部門が融資先の債務不履行を予見するため、財務諸表データを過去2年分まで分析にかけていました。この分析には10時間以上も時間がかかっており、より詳しく分析するために過去3年分へと分析データを増やすことはシステムの性能上難しい状況でした。

これもAsakusa FrameworkとHadoopの採用によって圧倒的な処理時間の改善を実現。3年分のデータ分析が7分程度で終了するようになり、今後のデータ増加に対してもノードを追加することで性能を向上させていけるスケールアウト型アーキテクチャの利点を生かすことができるようになっています。

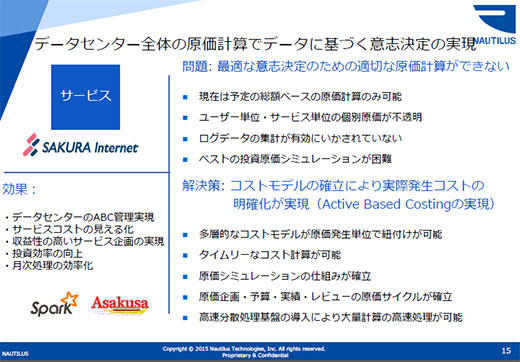

データセンター事業者のさくらインターネットでは、これまでおおまかにしか把握してこなかったデータセンター全体の原価計算にAsakusa FrameworkとSparkを活用。

土地、人件費、サーバ、ネットワーク、電力にいたるまでデータセンターの原価に関わる情報を可能な限り収集し、コスト計算。あるサービスが儲かっているのかどうかといった判断がタイムリーにできるようにできるようになりました。

これにより同社は、いままでやりたかったけれどもあきらめていたことを実現できるようになった、といいます。

同社によるAsakusa FrameworkとHadoopやSparkによるソリューションの構築は、Amazon Web ServicesかMicrosoft Azureを選択可能。また同社はAsakusa Frameworkのプラットフォーム―サービスである「Node0 DBR(Distributed Batch Runtime)」も提供しています。

ビッグデータ活用のツールをMicrosoft Azureで提供

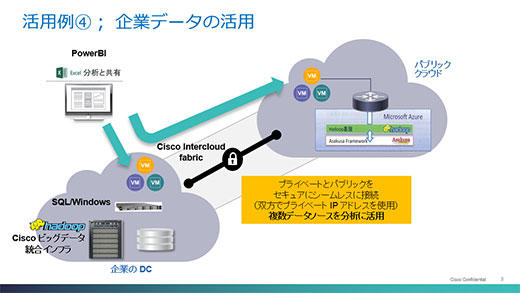

集めてきたデータをビジネスで生かすためには、分かりやすい形で可視化すること、そしてそれを基に意思決定を支援するツールが大事だと説明するのは、日本マイクロソフト プリンシパルテクノロジーストラテジスト 北垣康成氏。

北垣氏は、同社のクラウドサービスであるMicrosoft Azureで提供しているビッグデータ向けソリューションについて1つ目のセッション「Microsoft Azureで実現するBig Data活用」で解説。

最初に紹介された「Azure Data Factory」は、「IoTやビッグデータではさまざまなデータフォーマットが使われる。それを集めて自由に変換し、分析プラットフォームに乗せていくツール。データ変換のためのプログラム作成などを極力不要にし、保守性も高い」(北垣氏)

Azure Data Factoryは、人気のオンラインゲーム「Halo」が毎日数十テラバイトの規模で生成するログファイルをマイクロソフト社内で処理し、Azure上のHaddopクラスタであるHDInsightやオンプレミスのSQL Serverなどで分析。新規ユーザーの流入数やユーザーの行動など、サービス向上のための情報収集に役立てているとのことです。

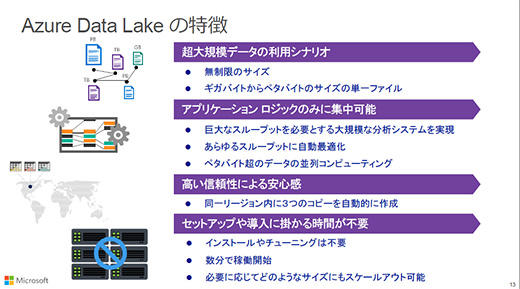

ビッグデータそのもの、つまり大規模なデータを保存するためのサービスが「Azure Data Lake」。さまざまなデータの容れ物としてデータをためていくためのサービスです。

「オンプレミスでは、データをなんでも貯めておくというのはストレージコストの関係で難しかった。しかしクラウドでは実現可能になってきた」(北垣氏)

Azure Data Lakeは数百テラバイトからペタバイトクラスの超大規模なデータの利用シナリオも想定したスケールアウト可能な設計になっており、数分でサービスが利用可能。しかもデータはリージョン内に3つのコピーが自動的に作成されるため、可用性も担保されます。

「こうした大規模なデータの操作は高速なI/Oやデータの無意味な移動などを防がないと、とたんに遅くなるため構築が難しい。しかしAzure Data Lakeではそうしたことはすべてクラウドがやってくれる」と北垣氏。

さらにクラウド上のデータウェアハウスとして「Azure SQL Data Warehouse」も用意しており、大規模なデータに対してSQLを用いてきめ細かな統計や分析を行う際に能力を発揮します。

分析結果を可視化し、意思決定を支援してくれるのが「Power BI」です。7月に新バージョンが登場し、Excelベースだったものが独立したツールとなりました。

Power BIは、Azureで提供されるサービスの「PowerBI.com Service」と、デスクトップPCで動作する「Power BI Desktop」の2つ形態で提供されます。

いずれも大量のデータを高速に分析、可視化する操作にフォーカスした使いやすいもの。ビジネスチャートだけでなく、地図サービスのBing Mapと連係して分析結果を地図上に表示することなども可能になっています。

関連記事

- Hadoopをデータウェアハウスに統合するメリットと、シスコが明かしたIoT戦略を作るフレームワーク[PR]

- データベースは変革の時、これからスケールアウト型のプラットフォームが主流になる背景とは?[PR]

(本記事はシスコシステムズ提供のタイアップ記事です)

あわせて読みたい

Google Compute Engine、いつもは自動で行うネットワーク操作を手動で行い、ミスに気付かず一部でネットワーク障害

≪前の記事

PHP 7正式版は、大きな問題がなければ来週12月3日登場予定。PHP 7RC8が公開